现实世界中存在大量未利用的先验知识和未标记数据。而在医疗等高价值领域,获取足够标记数据训练机器学习模型尤其困难,这限制了传统监督学习算法的应用。尽管深度学习方法在其他领域取得了显著进展,但在表格数据分类上仍未能超越传统的机器学习方法,如梯度提升树。TabLLM 旨在利用大模型(LLMs)的丰富知识库,通过自然语言处理能力,将表格数据转换为文本表示,从而在零样本或少样本的条件下进行有效分类。这种方法能够在数据标记受限的情况下,利用模型的先验知识提高分类性能,尤其是在面对罕见或特殊情形时。

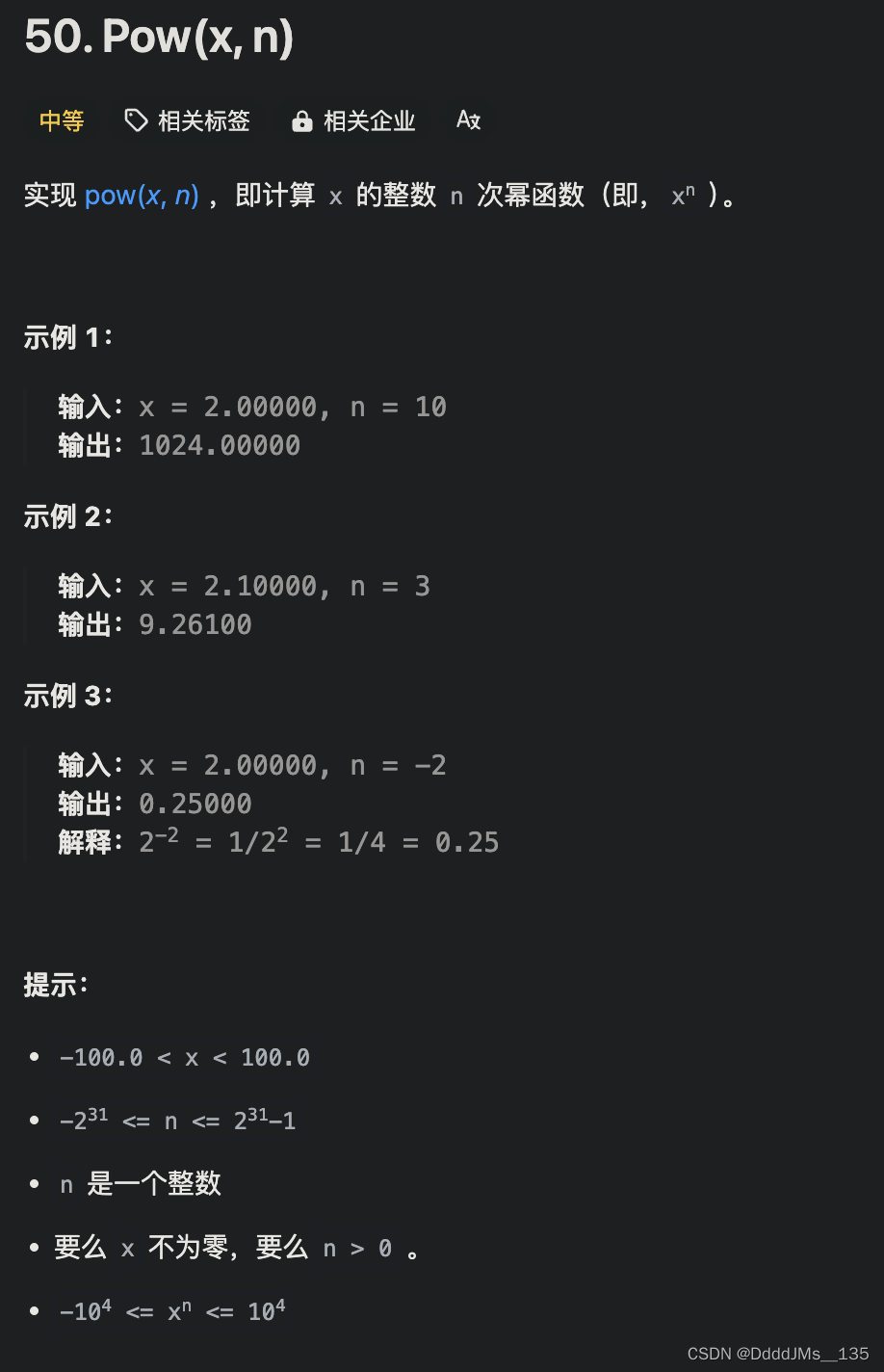

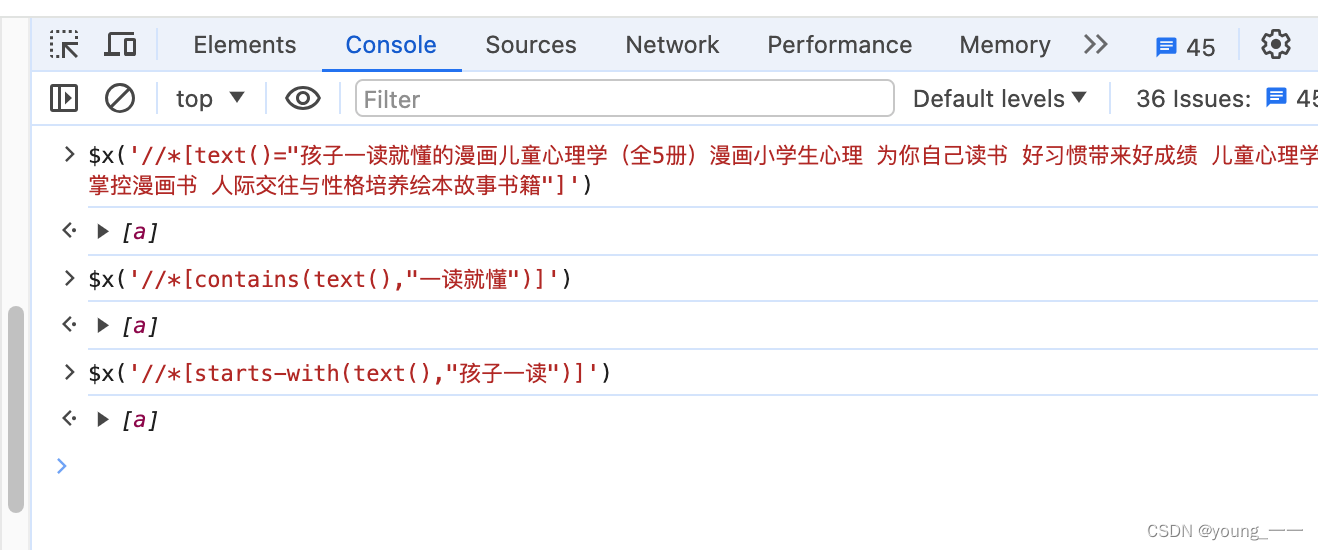

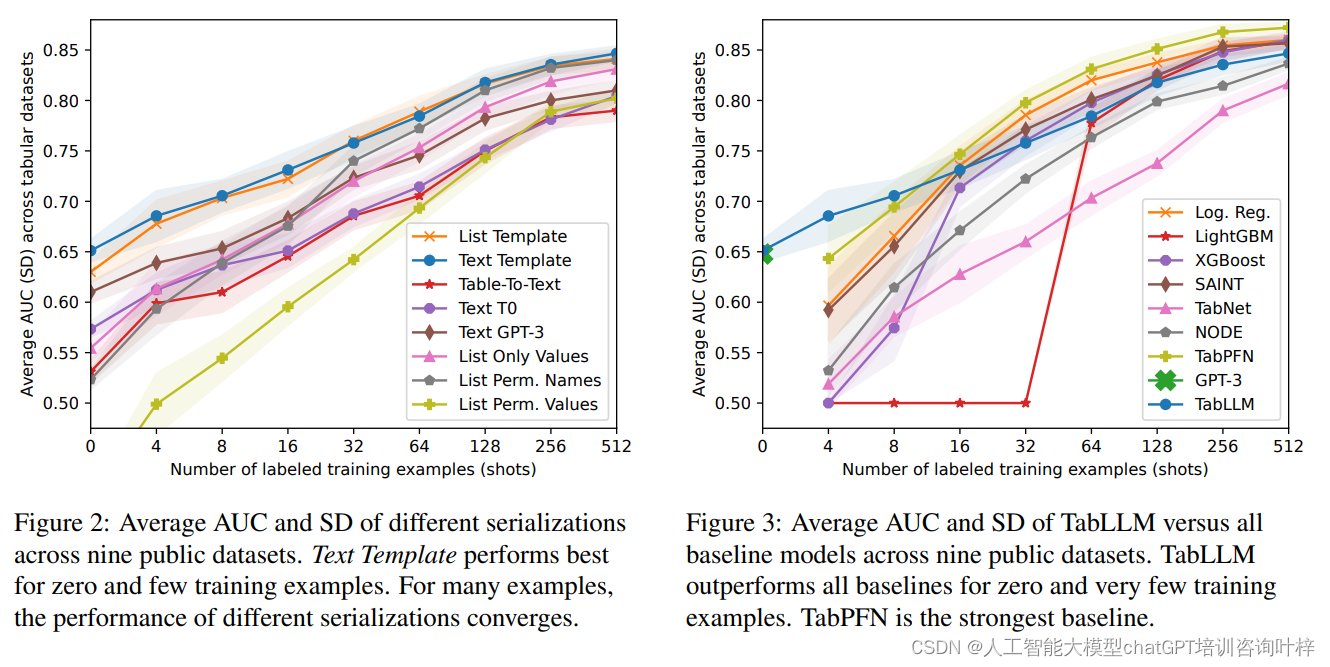

研究者们探索了不同的序列化技术,包括列表模板、文本模板、表格到文本模型,以及使用大型语言模型(如T0和GPT-3)进行序列化。

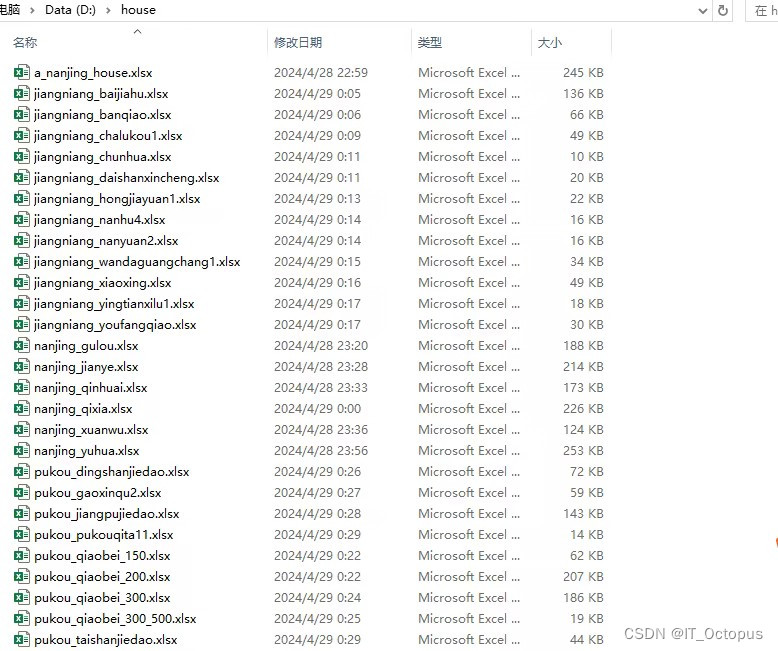

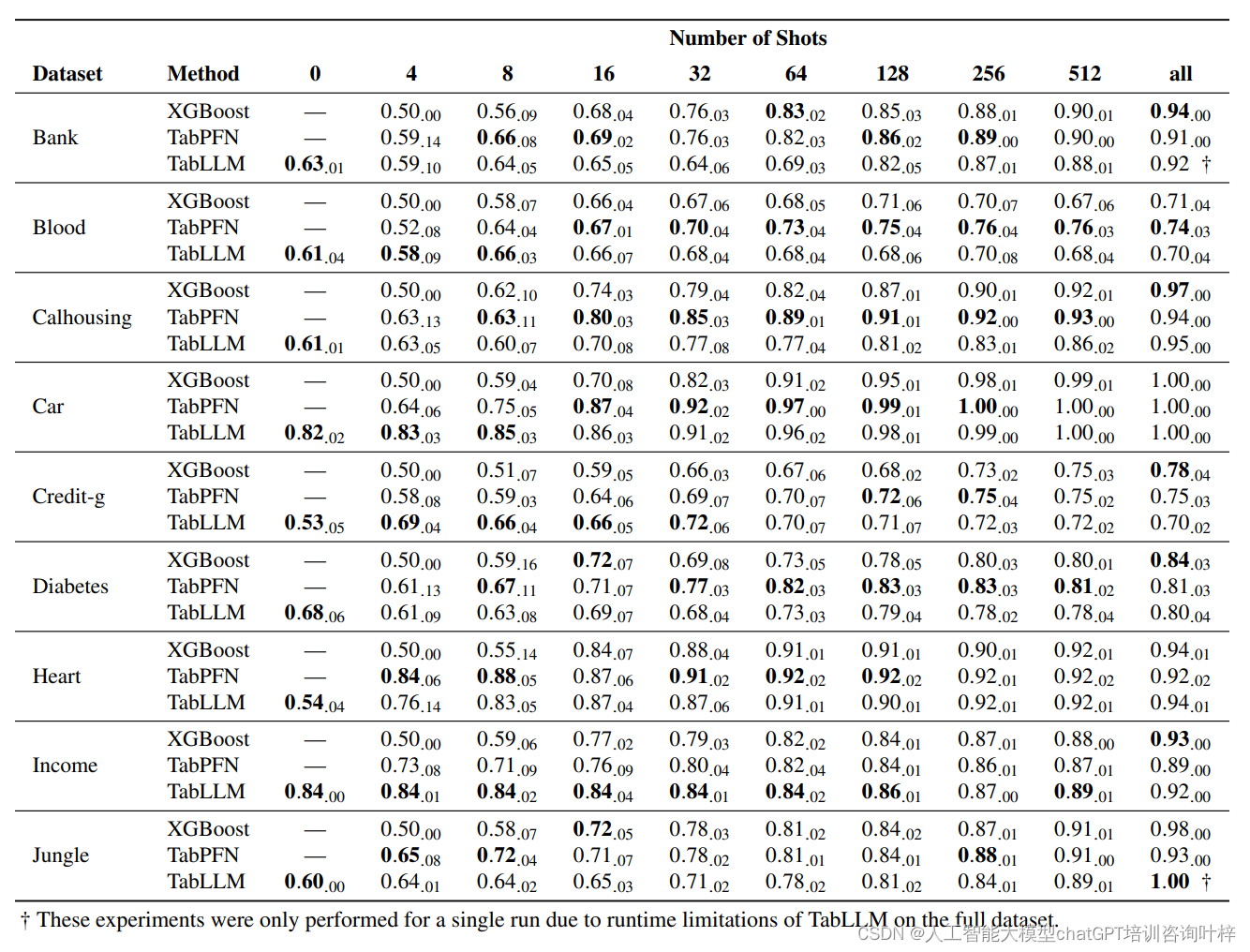

TabLLM框架的性能评估是在多个基准数据集上进行的,旨在展示TabLLM在表格数据分类任务上的表现,并与其他现有的深度学习方法以及传统的机器学习方法进行比较。

评估过程中,TabLLM在不同的数据集上接受了测试,包括在零样本(zero-shot)和少样本(few-shot)的设置下。这些测试允许研究者们评估模型在没有或只有很少训练数据时的性能。结果表明,TabLLM在多个数据集上都取得了有竞争力的结果,特别是在标记数据非常有限的情况下。

在与深度学习方法的比较中,TabLLM展现了其简单而有效的特点。尽管深度学习方法在其他领域表现出色,但在表格数据分类上,TabLLM却能够提供与这些方法相比拟或更好的性能。此外,与传统的机器学习方法(如梯度提升树)相比,TabLLM在少样本设置下显示出了显著的优势,甚至在某些情况下超过了这些传统方法。

性能评估还包括了对不同序列化技术的影响分析。序列化是将表格数据转换为语言模型可以处理的自然语言格式的过程。研究发现,不同的序列化方法对模型性能有显著影响,其中一些方法在特定情况下表现得更好。

即使在没有标记数据的情况下,TabLLM也能够利用大型语言模型的先验知识进行有效的分类。当提供少量标记数据进行微调时,TabLLM的性能可能进一步提高,显示出其在样本效率上的潜力。

这些实验结果对于证明TabLLM作为一种新型分类方法的有效性至关重要,特别是在传统的监督学习方法面临挑战的情境下。通过这些比较,研究者们能够展示TabLLM在实际应用中的潜力,尤其是在数据标记资源受限的领域。

论文:https://arxiv.org/abs/2210.10723

代码:https://github.com/clinicalml/T